labml.ai 带注释的 PyTorch 版论文实现

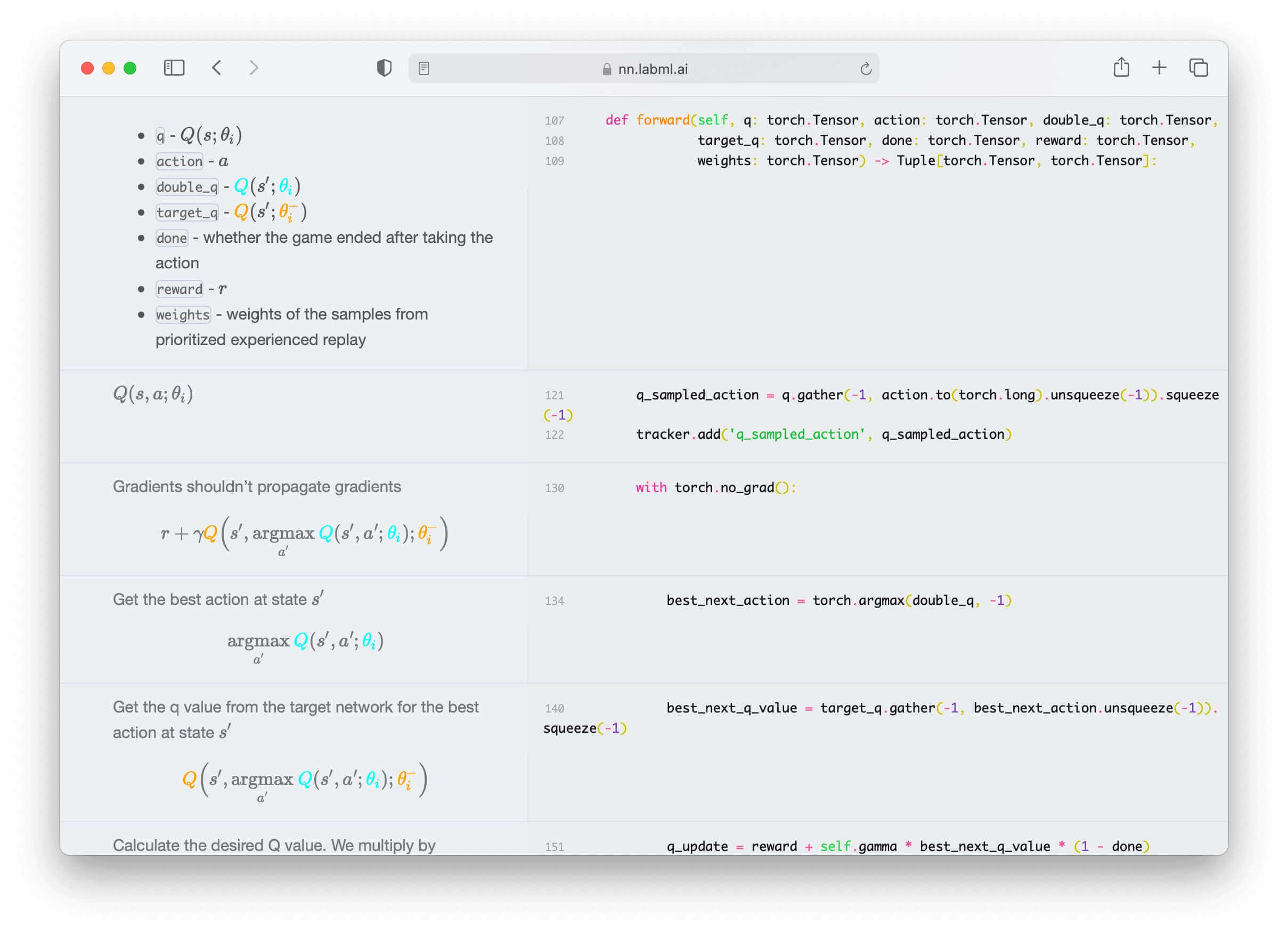

这是一个用 PyTorch 实现各种神经网络和相关算法的集合。每个算法的代码实现都有详细的解释说明,且在网站上与代码逐行对应。我们相信,这些内容将帮助您更好地理解这些算法。

论文实现

✨ Transformers

- 多头注意力

- Transformer 构建模块

- Transformer XL

- 相对多头注意力

- 旋转式位置编码 (ROPE)

- 线性偏差注意力 (AliBI)

- RETRO

- 压缩 Transformer

- GPT 架构

- GLU 变体

- kNN-LM:通过记忆实现泛化

- 自反馈 Transformer

- Switch Transformer

- 快速权重 Transformer

- FNet

- 无注意力 Transformer

- 掩码语言模型

- MLP-Mixer:一种用于视觉的全 MLP 架构

- 门控多层感知器 (gMLP)

- 视觉 Transformer (ViT)

- Primer

- 沙漏网络

✨ Eleuther GPT-neox

✨ 扩散模型

✨ 生成对抗网络

✨ 循环高速路网络

✨ LSTM

✨ 超网络-HyperLSTM

✨ ResNet

✨ ConvMixer

✨ 胶囊网络

✨ U-Net

✨ Sketch RNN

✨ 图神经网络

✨ 强化学习

✨ 虚拟遗憾最小化(CFR)

使用 CFR 解决诸如扑克等不完全信息游戏

✨ 优化器

✨ 归一化层

✨ 蒸馏

✨ 自适应计算

✨ 不确定性

✨ 激活函数

✨ 语言模型采样技术

✨ 可扩展训练/推理

安装

pip install labml-nn© 版权声明

文章版权归作者所有,未经允许请勿转载。