语言模型架构概述

我们首先来熟悉一些架构术语。

编码器和解码器

- 编码器:处理输入数据并将其转换为浓缩表示,以捕获基本信息。在翻译任务中,编码器获取英文句子并将其转换为表示其语言特征和含义的向量。

- 解码器:采用编码表示并生成输出,通常采用不同的形式。在同一个翻译任务中,解码器采用英语句子的编码表示并生成其法语对应表示。

仅编码器型号

- 示例:基于 BERT 的模型

- 预训练方法:掩蔽语言模型 (MLM)

- 用例:需要深入了解输入数据的任务。这些模型对于分类、情绪分析和信息提取非常有效。

仅解码器模型

- 例如:GPT、XLNet

- 预训练方法:下一个标记预测

- 用例:生成任务。它们通过以自回归方式根据提供的上下文预测后续文本来工作。它们的主要功能是生成输出,无需单独的编码阶段。

编码器-解码器模型

- 例如:T5、BART、Google Gemini(可能)

- 预训练:与任务相关

- 用例:涉及理解和生成数据的任务。它们首先将输入序列编码为内部表示,然后将此表示解码为输出序列。

比较这些架构的用途,我们首先可以轻松排除仅编码器模型:它们通常用 MLM 进行预先训练,并不一定有助于生成输出。

另一方面,仅使用解码器的模型非常有意义:它们用于生成输出,并在下一个标记预测任务上进行预训练,这正是大多数 LLM 的任务。

问题实际上可以归结为仅解码器与编码器-解码器架构:

有了解码器组件并由此具有生成能力,再添加编码器组件不是更有帮助吗?

因果解码器(CD)与编码器-解码器(ED)

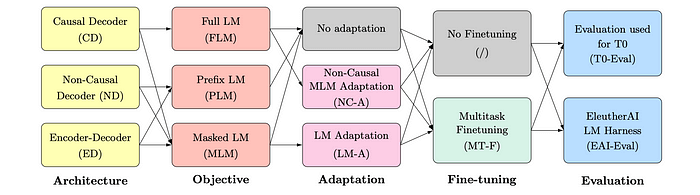

人们长期以来一直在研究仅解码器(也称为因果解码器)相对于编码器-解码器模型的性能。早期的研究之一是Wang 等人在 ICML 2022 上发表的论文《哪种语言模型架构和预训练目标最适合零样本泛化?》。在这项研究中,研究人员比较了各种架构和预训练方法的组合。他们发现:

我们的实验表明,在自回归语言建模目标上训练的因果解码器模型在纯自监督预训练后表现出最强的零样本泛化。

然而,在我们的实验中,使用掩蔽语言建模目标进行训练并随后进行多任务微调的输入具有非因果可见性的模型表现最佳。

好的,那么编码器-解码器 > 仅解码器 > 仅编码器,对吗?

事实证明,尽管上述论文为开发更大的模型提供了一些有价值的见解。 在选择架构时还需要考虑一些其他因素。

培训费用

为了发挥 ED 的最大潜力,我们需要对标记数据执行多任务微调(基本上是指令微调),这可能非常昂贵,特别是对于较大的模型而言。

另一方面,CD 模型凭借其强大的零样本泛化能力实现了出色的性能,这与当前的惯例——在大规模语料库上进行自监督学习——配合得很好。

突发能力

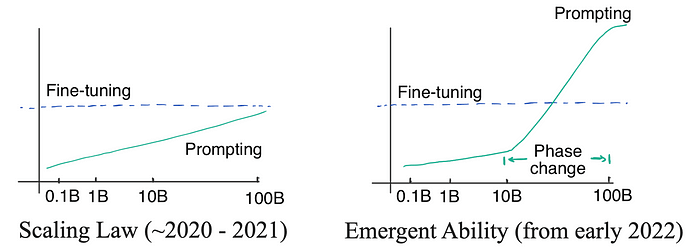

论文中比较的模型有大约 50 亿个参数,训练了超过 1700 亿个 token。这个规模还不足以解释LLM 的奇迹——即涌现能力。

大型语言模型 (LLM) 中的新兴能力是指模型展示出在训练过程中未明确教授的新的、复杂的能力的现象,这些能力会随着模型规模和复杂性的扩大而自然产生。

本质上,新兴能力使 LLM 能够执行一定程度的复杂推理。例如,从非结构化文本中提取结构化知识。这种能力使 LLM 能够理解一些自然存在于其所训练的文本语料库中的 NLP 任务。对于较简单的任务,我们可以考虑使用在训练过程中已经微调的新兴能力的 LLM,而对于较复杂的任务,它可以将其分解为更简单的任务。新兴能力不一定比 ED 模型更有利于仅使用解码器的模型,但它们可以缩小 ED 模型与使用多任务微调的仅使用解码器的模型之间的性能差距。

根据提示进行情境学习

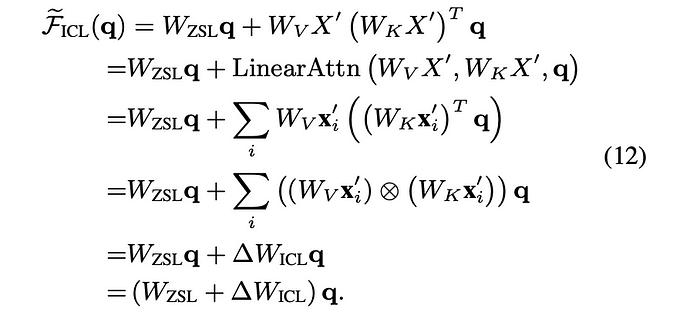

另一件需要考虑的事情是提示。使用 LLM 时,我们可以应用提示工程方法,例如提供少量样本示例来帮助 LLM 理解上下文或任务。研究人员从数学上证明了这种上下文信息可以被视为具有与梯度下降类似的效果,可以更新零样本提示的注意力权重。

如果我们认为提示会给注意力权重引入梯度,那么我们大概可以预期它对仅使用解码器的模型有更直接的影响,因为它不需要先转换成中间上下文再用于生成任务。从逻辑上讲,它应该仍然适用于编码器-解码器架构,但它需要对编码器进行仔细调整,以获得最佳性能,这可能很难。

效率优化

在仅解码器模型中,解码过程中,先前标记的键 (K) 和值 (V) 矩阵可重用于后续标记。由于每个位置仅关注先前的标记(由于因果注意机制),因此这些标记的 K 和 V 矩阵保持不变。这种缓存机制通过避免重新计算已处理标记的 K 和 V 矩阵来提高效率,从而有助于在 GPT 等自回归模型中进行推理时更快地生成并降低计算成本。

自回归与双向注意力

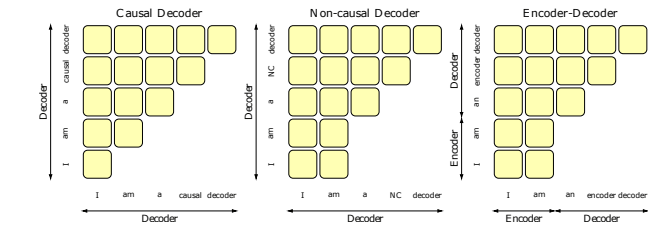

关于底层注意力机制的差异,还有另一个有趣的观点,即仅解码器(因果解码器)的自回归和编码器-解码器的双向。我们可以在下面直观地看到它们如何关注不同的位置:

在 Transformer 架构中,注意力矩阵的计算方式是将两个低维矩阵(Q 和 K^T)相乘,然后应用 softmax 运算。在仅解码器架构中,由于因果掩蔽(以防止模型看到未来的标记),注意力矩阵被限制为下三角形式,理论上保持其满秩状态:对角线中的每个元素(代表自注意力)都有助于使行列式为正(您只能从 softmax 获得正结果)。满秩状态表明理论上表达能力更强。

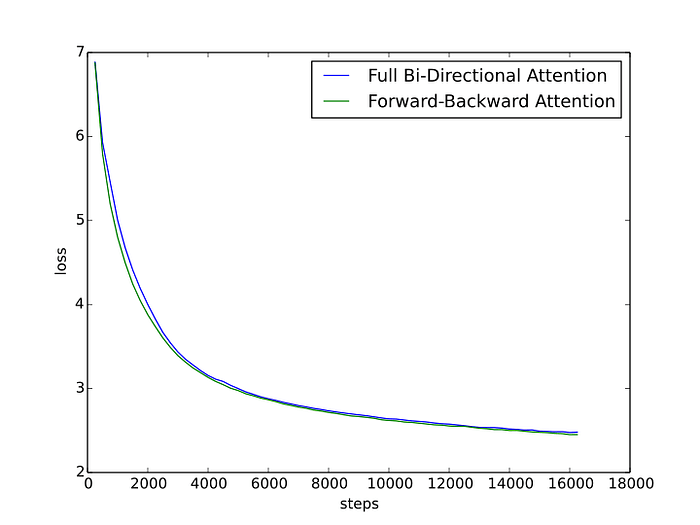

另外两种生成式架构都引入了双向注意力,因此不能保证注意力矩阵的满秩状态。作者认为这会限制模型的性能。他设计了一个实验来验证这一假设,将双向注意力矩阵拆分为单向,一半注意力头关注前向,另一半关注后向。然后,他将这种前向-后向注意力与全双向注意力模型的性能进行了比较。FB 注意力确实表现更好,这在某种程度上验证了这一理论,但改进幅度很小,似乎并没有显示出显着差异,尤其是在模型经过充分训练的情况下。

这在直觉上是有道理的。双向注意力就像一把双刃剑:它加速了学习过程,但同时也“破坏”了模型学习生成所必需的更深层次的预测模式。你可以把它想象成学习如何写作:填空比逐字逐句地写整篇文章更容易,但这是一种效率较低的练习方式。然而,经过大量的训练,这两种方法都实现了学习如何写作的目标。

我学到了什么

仅解码器架构之所以受欢迎,是因为它简单、零样本泛化能力强,而且训练成本较低,可以获得合理的性能。目前已经有很多研究仅解码器架构和编码器-解码器架构性能的工作,但考虑到训练和模型大小足够,并没有确凿的证据证明一种架构在最终性能方面优于另一种架构。

事实上,Google Gemini 展示了编码器-解码器模型如何在某些任务中同样出色地工作,甚至超越仅使用解码器的架构。编码器组件支持“内置多模态性”,因为它可以从非文本输入中提取信息,这对于未来一代的 LLM 来说可能至关重要。我们最初的问题应该是——为什么大多数 LLM 都是仅使用解码器的——它表明了一个时代,当时每个人都主要致力于推进仅使用解码器的架构。尽管如此,我认为它仍然揭示了大量的见解,有助于理解 LLM 工作的内部机制及其发展的历史。